01

在布莱切利园

为人工智能新时代打开大门?

2023年11月1日,包括美国和中国在内的28个国家和欧盟达成《布莱切利宣言》(Bletchley Declaration),旨在推动全球在人工智能(AI)安全方面的合作。

该宣言在英国中部布莱切利园(Bletchley Park)举办的人工智能安全峰会开幕当天发表。

峰会汇聚了来自国际政府、领先的人工智能公司、民间社会团体的代表和研究专家共120人思考人工智能的风险,特别是“前沿人工智能”的风险。

而所谓“前沿人工智能”,即能够执行各种任务并对公共安全构成未知风险的尖端系统。这些系统由大型语言模型支撑,而模型则是在大量文本和数据池中训练出来的。

峰会的焦点集中在前沿的人工智能模型可能面临的失控和滥用,并讨论如何通过国际协调行动减轻此类风险。在谈到最先进的人工智能系统带来的风险时,宣言指出:

这些人工智能模型最重要的功能可能会有意或无意地造成严重甚至灾难性的伤害。

一些专家认为,在一系列任务中,这些最尖端的系统可能会变得比人类更聪明。

埃隆·马斯克(Elon Musk)在峰会期间发表讲话警告说:

我们第一次遇到这样的情况,有种东西会比最聪明的人类还要聪明得多……我不清楚我们能否真正控制这样的东西。

这应了多年前艾伦·图灵(Alan Turing)的一个判断:“如果机器能够思考,它可能比我们思考得更聪明。”

出席会议的美国副总统卡玛拉·哈里斯(Kamala Harris)在伦敦美国大使馆发表演讲时说,世界需要从现在开始采取行动,应对人工智能的“全方位”风险,而不仅仅是大规模网络攻击或人工智能制造的生物武器等生存威胁。

她表示,人工智能的日常威胁也需要人们采取行动,因为这些威胁目前正在造成伤害,而且对普通人来说也构成生存威胁。

她举例说,一位老人因为人工智能算法出错而被踢出了医疗保健计划,或者一位妇女受到了虐待她的伴侣用深度伪造照片进行的威胁。

哈里斯的发言人克尔斯滕·艾伦(Kirsten Allen)说,目标应该是建立一个 “人人都能免受人工智能危害,人人都能平等分享人工智能带来的好处”的未来。

在被问及哈里斯关注人工智能的短期风险与峰会明显关注的长期风险之间的差异时,英国峰会的首席顾问马特·克利福德(Matt Clifford)坚称,这次活动“并不专注于长期风险,峰会的重点是明年的模型”。

宣言鼓励开发前沿人工智能技术的参与者在衡量、监控和减轻潜在害处的计划中保持透明度和问责制。

它制定了一个双管齐下的议程,重点是识别共同关注的风险,建立对这些风险的科学理解,并制定跨国政策对其加以缓解。

宣言称:

这包括在提高开发人工智能前沿能力的私营行为者的透明度的同时,制定适当的评估指标、安全测试工具,以及发展相关的公共部门能力和科学研究。

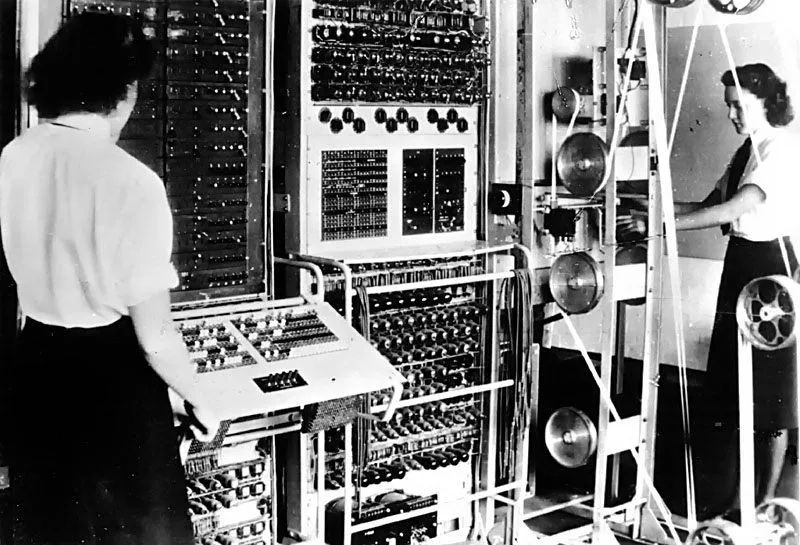

会议的地点显然经过精心的选择。布莱切利园,这座位于伦敦北部的历史悠久的庄园,曾是二战英国密码破译人员的基地。由于战争期间密码学和情报处理的进步,该基地被认为是计算的诞生地。

▲ 在布莱切利园投入使用的Colossus计算机

在布莱切利园,密码破译者开发了世界上第一台可编程数字计算机 Colossus,破解了纳粹的恩尼格玛密码机(Enigma),帮助结束了战争。

最著名的密码破译者包括数学家艾伦·图灵,因在破解恩尼格玛中发挥的关键作用,他赢得了“计算机科学之父”的美名。

图灵、欧文·约翰·古德(Irving John Good)和唐纳德·米奇(Donald Michie)就“智能机器”和现代计算进行了大量研究和写作,堪称人工智能的先驱。

英国技术大臣米歇尔·多尼兰(Michelle Donelan)在峰会开幕前说:“80年前在布莱切利园发生的事情打开了新信息时代的大门,而本周发生的事情将为人工智能新时代打开大门。”

全球各国政府都在争先恐后地为人工智能发展制定指导方针。方此之际,全球对手与盟友就遏制人工智能风险达成首个协议,正如多尼兰所评论的:“各国现在第一次一致认为,我们需要不仅独立地、而且集体地审视前沿人工智能的风险。”

在此意义上,让主要国家和地区达成协议堪称一大成就,尽管该协议愿景很多而细节较少,并且未能提出规范人工智能发展的方法。

迄今为止,国际社会对于一整套全球人工智能法规可能是什么样子,或者应该由谁来起草,几乎不能形成一致意见。

一些英国官员曾希望其他国家能同意加强英国政府的人工智能工作组,以便在向公众发布新模型之前,利用该工作组对来自世界各地的新模型进行测试。

相反,美国商务部长吉娜·雷蒙多(Gina Raimondo)利用这次峰会宣布在美国国家标准与技术研究院内成立一个独立的人工智能安全研究所,她称之为“中立的第三方,以制定同类最佳的标准”,并补充说,该研究所将制定自己的安全、保密和测试规则。

如果有人希望峰会能够宣布建立一个新的全球人工智能研究机构,那么这些希望陷入了破灭。目前,各国仍在专注于自己的努力。唯一可以期待的,是未来看到《布莱切利宣言》所倡导的这些不同机构之间的合作。

显然,这场为期两天的峰会并不能够为全球立法奠定基础,但它显示了国际社会努力在人工智能这一既令人兴奋又令人担忧的新兴技术领域内确定前进的道路。与会国承诺就人工智能风险达成“共同协议和责任”,并举行一系列后续会议。

韩国将在六个月内举行小型虚拟人工智能峰会,一年后法国将举办现场峰会,旨在继续在解决人工智能安全问题和促进负责任的人工智能发展方面开展合作。

▲ 图源Pexels

02

当前人工智能国际治理的软肋

然而峰会也并非一帆风顺。美国和欧洲官员曾表示要与“志同道合的国家”合作,共同制定人工智能准则。尽管中国也受邀参加了此次峰会,但峰会发起者英国首相里希·苏纳克(Rishi Sunak)所在的保守党的一些议员曾呼吁取消对中国的邀请。

苏纳克针对中国本应被排除在外的批评,为邀请中国进行了辩护,他说:

如果不至少尝试让世界上所有主要的人工智能大国参与进来,就不可能有严肃的人工智能战略。这可能不是一件容易的事,但却是一件正确的事。

在峰会上,雷蒙多、多尼兰和中国科技部副部长吴朝晖一起登台,这是罕见的全球团结表现。负责组织峰会的一位英国官员称雷蒙多和吴朝晖一起出现在台上是“一个非凡的时刻”。

中国签署了宣言,其中包括这样的段落:

我们欢迎国际社会迄今为人工智能合作所做的努力,以促进包容性经济增长、可持续发展和创新,保护人权和基本自由,促进公众对人工智能系统的信任和信心,充分发挥其潜力。

吴朝晖对与会代表指出:

我们秉持相互尊重、平等互利的原则。各国无论大小、规模如何,都有开发和使用人工智能的平等权利。

这是一个很关键的原则。人工智能在世界范围内的不平等扩散会造成国际范围内的公平正义问题,即人工智能带来的便利较多惠及发达国家,而造成的负面影响较多殃及发展中国家。

这就是为什么当前对人工智能的治理不能只关注国家层面,国际层面的治理也变得越来越紧迫。

在峰会开始前,100多个国际组织、专家和活动人士签署了致苏纳克的公开信,表达了对以“闭门”方式举办这次峰会的不满,以及对会议被科技巨头主导、而民间社会的参与受限的不满。

公开信警告说,“受人工智能影响最严重的社区和工人已被峰会边缘化”,而少数精英则寻求制定规则。

公开信将峰会限制具有多样性专业知识和观点的民间社会组织的参与称为“一个错失的机会”。

它抨击政府将那些正在遭受伤害的人以及批评者和活动人士的声音排除在峰会之外,允许创建人工智能系统并从中获利的企业来制定议程。

公开信担忧,如此做法可能令公民面临大规模错误和偏见,从而妨碍人工智能的民主化。

▲ 图源Pixabay

峰会的第一天,参加活动的十几名民间社会参与者发出一封紧急信函,认为峰会上的讨论回避了重大问题。

这些参与者认为,虽然前沿模型的潜在危害可能促成了这次峰会,但眼下使用的人工智能系统已经对人们的权利和日常生活产生了重大的有害影响。

这意味着,需要关注“此时此地”的人工智能威胁,而不是超级人工智能的存在性风险(尽管许多研究该领域的人认定确实有可能存在这种风险)。

紧急信函的签署者之一、民主与技术中心首席执行官亚历山德拉·里夫·吉文斯(Alexandra Reeve Givens)称,起草这封信的原因是:

我们担心峰会对长期安全危害的狭隘关注可能会让政策制定者和公司忽略一种迫切需求,即解决人工智能系统已经影响到人们权利的问题。

比如,峰会很少讨论人工智能可能对数据标签者造成的危害,而数据标签可以说是人工智能发展最基础的部分。在迫切需要加强对数据工作者的劳动保护的情况下,他们却经常被排除在负责任的人工智能发展的对话之外。

公开信还要求峰会的参与者确保“不允许公司布置和批改自己的作业。任何旨在为人工智能政策行动提供信息的研究工作都必须明确独立于行业影响”。

峰会的一大缺陷在于,只侧重那些有利于已经成功开发出人工智能工具的在位公司的讨论要点。批评者认为,受邀参加活动的人员名单也使对话偏向于维持现状。

公开信提出:

人工智能政策对话必须引入更广泛的声音和观点,特别是来自北半球以外地区的声音和观点,这一点至关重要。

《布莱切利宣言》通过后,苏纳克表示:

这是一项具有里程碑意义的成就,显示出世界上最强大的人工智能国家在理解人工智能风险的紧迫性方面达成了共识,有助于确保我们子孙的长远未来。

这一志得意满的总结恰好也暴露了当前人工智能国际治理的一个软肋,即它在本质上仍然是由发达国家主导的多边合作,而发展中国家和欠发达国家的规则制定权和解释权在很大程度上被忽略。

因此,现有的人工智能多边治理更多是一种由发达国家主导的治理,而不是真正的国际治理。

▲ 图源Pixabay

03

国际性风险通过国际合作来解决

吴朝晖在峰会上指出,人工智能技术“不确定、无法解释、缺乏透明度”。“它带来了伦理、安全、隐私和公平方面的风险和挑战。它的复杂性正在显现”,因而,中国“呼吁全球合作,分享知识,并在开源条款下向公众提供人工智能技术”。

就在峰会开幕之前,美国总统乔·拜登(Joe Biden)发布了一项备受期待的行政命令,要求 OpenAI 和谷歌等美国人工智能公司在发布人工智能模型之前与政府分享其安全测试结果。政府表示,还将制定严格的测试指南。

该命令称:

当我们在美国国内推进这一议程时,政府将与国外的盟友和合作伙伴合作,建立一个强有力的国际框架来管理人工智能的开发和使用。

该命令规定,对人工智能生成的内容打上标签和水印,以帮助区分真实的交互和软件生成的交互。

命令还寻求促进隐私、公民权利、消费者保护和工人权利,因为“不负责任地使用人工智能可能会导致并加深司法、医疗保健和住房领域的歧视、偏见和其他滥用行为”,并保护消费者、患者、学生和可能因人工智能而面临工作风险的支持人员。

虽说拜登签署的人工智能行政命令,是迄今为止美国最广泛的监管尝试,但假如没有国会的行动,拜登政府所能取得的成果是有限的。

目前世界各地的其他立法机构在制定人工智能法案方面正在超过美国。

欧盟预计将在今年年底前就《人工智能法》达成协议,如获通过,该法案将成为第一个人工智能法规,也是世界上第一部全面的人工智能法律。

《人工智能法》的目标与《布莱切利宣言》的目标一致,即确保整个欧盟使用的人工智能系统安全、透明并受到人类监督,以防止产生有害结果。

▲ 图源Pixabay

在另一方面,《宣言》建议各国考虑支持与创新相称的治理和监管方法,以最大限度地发挥人工智能的好处,同时保持对其风险的警惕。

例如,可以根据国情和适用的法律框架进行风险分类和归总。这也是拟议当中的欧盟《人工智能法》打算采取的方法,可以称之为 “精准监管”,尤其重在刑事司法、招聘和医学等高风险领域监督人工智能的使用。

这种方法根据风险级别对人工智能应用程序进行分类,并对风险较高的应用程序进行更严格的监管。而一些风险最高的应用(例如,使用生物识别标识符实时跟踪人员)将被彻底禁止。

AI在国家层面上的治理表现出较强的政策模仿,这就造成尽管人工智能治理模式从表面上看可能有数十种,但若去除这些模式中的相似因素,似乎真正能够把这些模式区别开的元素并不多。

也因此,当前如火如荼的治理规则竞争有可能促使国际人工智能治理体现出更大的相似性,而非差别性。

美国和中国现有的治理实践表明,这两个国家的人工智能治理呈现出与欧盟趋同的趋势。

三大国家和地区人工智能治理的趋同性对于构建人工智能国际治理框架具有重要意义,因为它表明国家间政治制度和意识形态的差异并不能阻止它们在AI治理问题上达成共识。

所以,《布莱切利宣言》代表了一个良好开端,全球行为者日益认识到人工智能的发展不能听凭机遇,被任意忽视,或单独由私营行为者负责。

《宣言》强调了按照安全优先、以人为本、值得信赖和负责任的方式设计、开发、部署和使用人工智能的重要性,因为人工智能系统的使用可能会在日常生活中大幅增加,包括住房、就业、交通、健康和司法。

《宣言》也呼吁国际社会采取行动,审查和解决人工智能系统可能产生的影响,特别关注人权保护、透明度、公平、问责、监管、适当的人类监督、伦理、减少偏见、隐私和数据保护。

基于操纵或创建欺骗性内容的能力而产生的不可预见的风险也被被作为一个关注点得到了明确说明。

《宣言》清楚地意识到:

人工智能带来的风险本质上是国际性的,因此最好通过国际合作来解决。

在《宣言》之后,人工智能政策制定者需要在国内和国际上重新思考,以引导人工智能的变革性技术朝着民主和对社会有益的方向发展。

这一宣言是一个里程碑式的成就,抑或只是一种空洞的姿态,完全取决于良好的意愿是否会带来有意义的行动。

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号